Transformerの原典を読む | 論文メモ: Attention Is All You Need - BioErrorLog Tech Blog

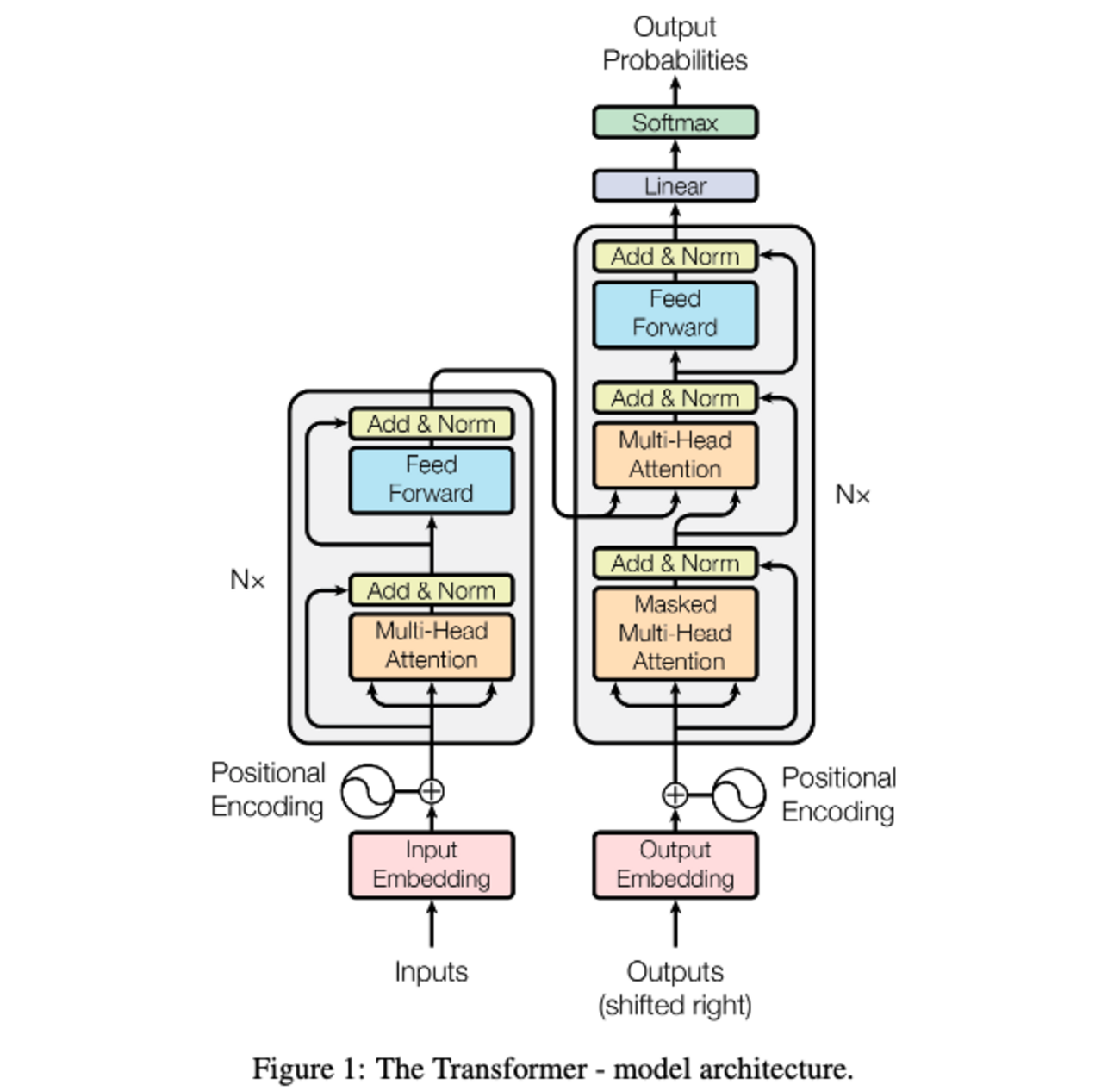

Transformerの原典である"Attention Is All You Need" の論文要約メモです。 はじめに Attention Is All You Need 概要 手法 モデルアーキテクチャ 学習方法 結果 翻訳タスク Transformerモデルバリエーション 英語構文解析 おわりに/所感 参考 はじめに かの有名なAttention Is All You Need、原典をちゃんと読んだことなかったので読みます。 arxiv.org 2017/06/12にv1公開 Google Brain / Google Research コード: t...| BioErrorLog Tech Blog